Apa itu Pelatihan Model SageMaker?

Pelatihan Model Amazon SageMaker mengurangi waktu dan biaya untuk melatih serta menyetel model machine learning (ML) dalam skala besar tanpa perlu mengelola infrastruktur. Anda dapat memanfaatkan infrastruktur komputasi ML beperforma tertinggi yang tersedia saat ini, dan Amazon SageMaker AI dapat secara otomatis menaikkan atau menurunkan skala infrastruktur, dari satu hingga ribuan GPU. Untuk melatih model deep learning lebih cepat, SageMaker AI membantu Anda memilih dan menyempurnakan set data dalam waktu nyata. Pustaka pelatihan terdistribusi SageMaker dapat membagi model besar dan set data pelatihan secara otomatis di seluruh instans AWS GPU atau Anda dapat menggunakan pustaka pihak ketiga, seperti DeepSpeed, Horovod, atau Megatron. Latih model fondasi (FM) selama berminggu-minggu dan berbulan-bulan tanpa gangguan dengan memantau dan memperbaiki klaster pelatihan secara otomatis.

Keuntungan pelatihan hemat biaya

Latih model dalam skala besar

Tugas pelatihan yang terkelola penuh

Tugas pelatihan SageMaker menawarkan pengalaman pengguna yang terkelola penuh untuk pelatihan FM terdistribusi besar, yang menghilangkan pekerjaan berat yang tidak terdiferensiasi di seluruh manajemen infrastruktur. Tugas pelatihan SageMaker secara otomatis menjalankan klaster pelatihan terdistribusi yang tangguh, memantau infrastruktur, dan memulihkan secara otomatis dari kesalahan untuk memastikan pengalaman pelatihan yang lancar. Setelah pelatihan selesai, SageMaker menghentikan klaster dan Anda akan ditagih untuk waktu pelatihan bersih. Selain itu, dengan tugas pelatihan SageMaker, Anda memiliki fleksibilitas untuk memilih tipe instans yang tepat agar paling sesuai dengan beban kerja individu (misalnya, melakukan pralatih model bahasa besar (LLM) pada klaster P5 atau menyempurnakan LLM sumber terbuka pada instans p4d) untuk lebih mengoptimalkan anggaran pelatihan Anda. Selain itu, tugas pelatihan SageMaker menawarkan pengalaman pengguna yang konsisten di seluruh tim ML dengan berbagai tingkat keahlian teknis dan tipe beban kerja yang berbeda.

SageMaker HyperPod

Amazon SageMaker HyperPod adalah infrastruktur yang dibangun secara khusus untuk mengelola klaster komputasi secara efisien guna menskalakan pengembangan model fondasi (FM). Hal ini memungkinkan teknik pelatihan model lanjutan, kontrol infrastruktur, optimisasi performa, dan peningkatan observabilitas model. SageMaker HyperPod dikonfigurasi sebelumnya dengan pustaka pelatihan terdistribusi SageMaker, yang memungkinkan Anda membagi model dan set data pelatihan secara otomatis di seluruh instans klaster AWS untuk membantu memanfaatkan infrastruktur komputasi dan jaringan klaster secara efisien. SageMaker HyperPod memungkinkan lingkungan yang lebih tangguh dengan mendeteksi, mendiagnosis, dan memulihkan dari kesalahan perangkat keras secara otomatis, yang memungkinkan Anda untuk terus melatih FM selama berbulan-bulan tanpa gangguan sehingga mengurangi waktu pelatihan hingga 40%.

Pelatihan terdistribusi performa tinggi

SageMaker AI membuat pelaksanaan pelatihan terdistribusi menjadi lebih cepat dengan secara otomatis membagi model dan set data pelatihan Anda di seluruh akselerator AWS. SageMaker AI membantu Anda mengoptimalkan tugas pelatihan untuk infrastruktur jaringan AWS dan topologi klaster. SageMaker AI juga menyederhanakan titik pemeriksaan model melalui resep dengan mengoptimalkan frekuensi titik pemeriksaan penghematan, yang memastikan overhead minimum selama pelatihan. Dengan resep, ilmuwan data dan developer dari semua keahlian mendapat keuntungan dari performa terbaik sambil memulai dengan cepat pelatihan dan penyempurnaan model AI generatif yang tersedia untuk umum, termasuk Llama 3.1 405B, Mixtral 8x22B, dan Mistral 7B. Resep tersebut mencakup tumpukan pelatihan yang telah diuji oleh AWS, sehingga Anda tidak perlu melakukan pekerjaan membosankan yang memerlukan waktu berminggu-minggu untuk menguji berbagai konfigurasi. Anda dapat beralih antara instans berbasis GPU dan berbasis AWS Trainium dengan perubahan resep satu baris serta mengaktifkan titik pemeriksaan model otomatis untuk ketahanan pelatihan yang lebih baik. Selain itu, jalankan beban kerja dalam produksi pada fitur pelatihan SageMaker pilihan Anda.

Alat bawaan untuk akurasi tertinggi dan biaya terendah

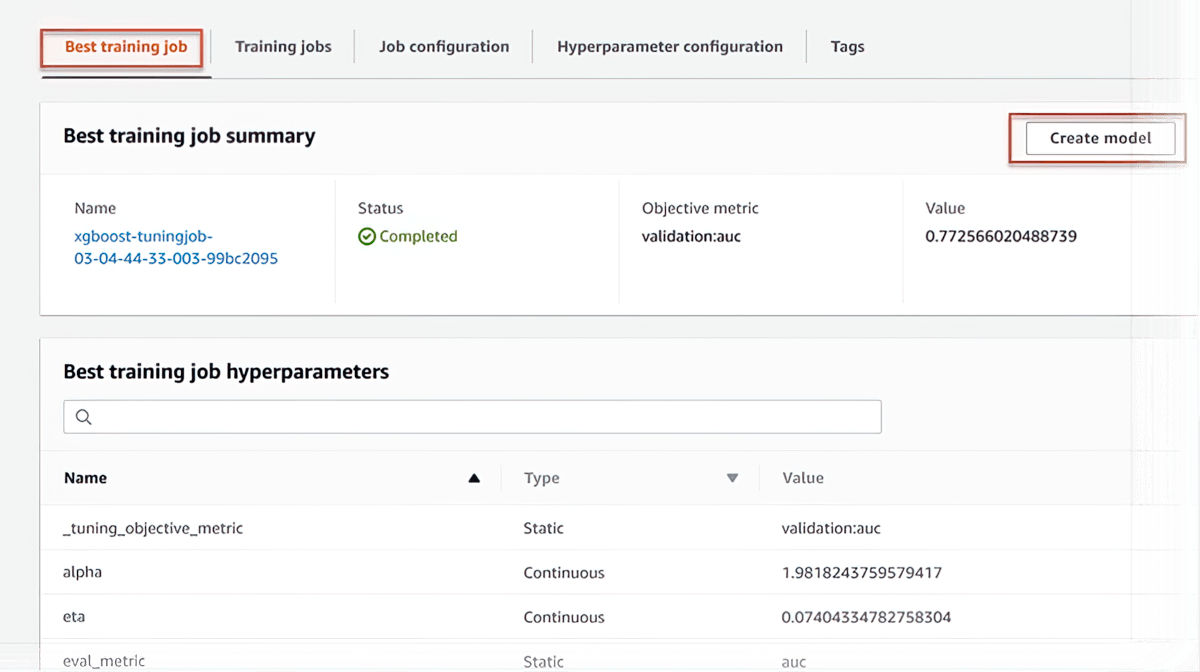

Penyetelan Model Otomatis

AI SageMaker dapat secara otomatis menyelaraskan model Anda dengan menyesuaikan ribuan kombinasi parameter algoritma untuk mendapatkan prediksi yang paling akurat, sehingga menghemat waktu berminggu-minggu. Hal ini membantu Anda menemukan versi model terbaik dengan menjalankan banyak tugas pelatihan pada set data Anda.

Pelatihan Spot Terkelola

AI SageMaker membantu mengurangi biaya pelatihan hingga 90 persen dengan menjalankan tugas pelatihan secara otomatis ketika kapasitas komputasi tersedia. Tugas pelatihan ini juga tahan terhadap gangguan yang disebabkan oleh perubahan kapasitas.

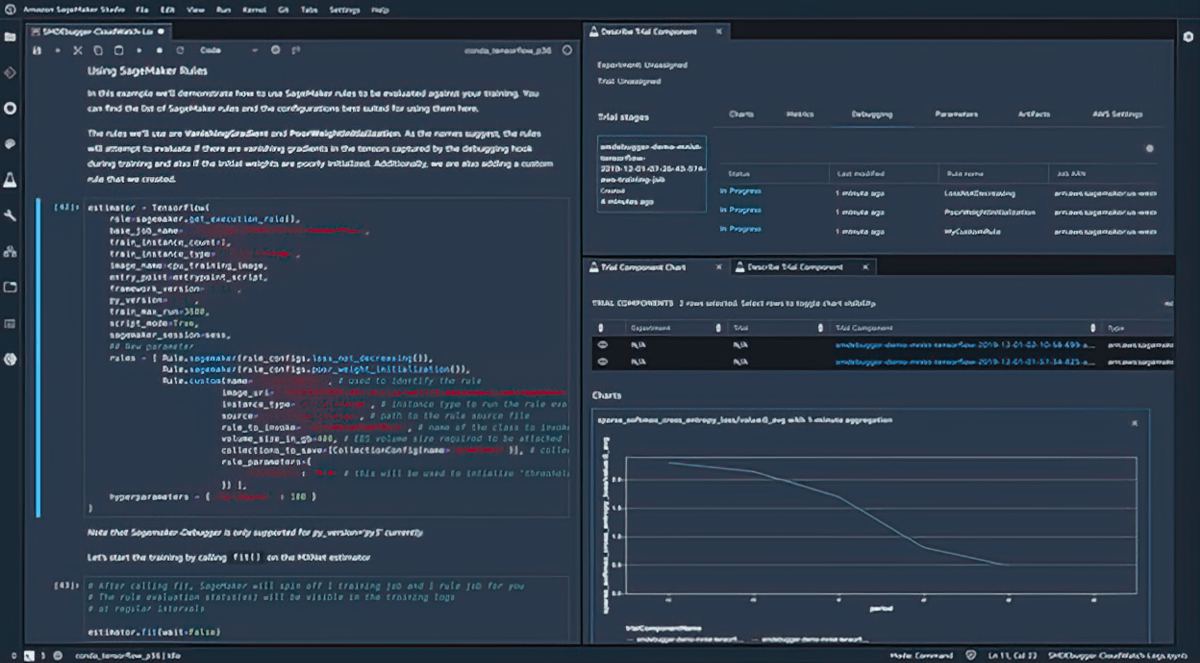

Debugging

Amazon SageMaker Debugger menangkap tugas pelatihan metrik dan profil secara waktu nyata sehingga Anda dapat dengan cepat memperbaiki masalah performa sebelum melakukan deployment model ke produksi. Anda juga dapat terhubung dari jarak jauh ke lingkungan pelatihan model di SageMaker untuk debugging dengan akses ke kontainer pelatihan yang mendasarinya.

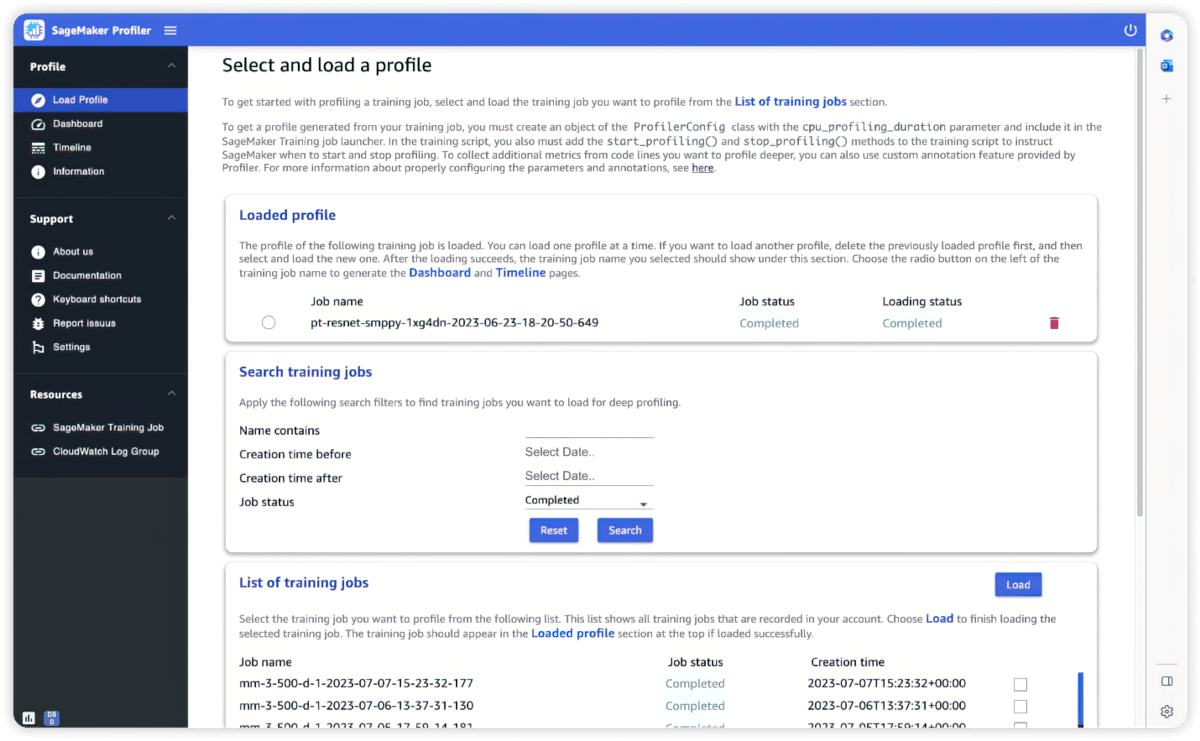

Profiler

Alat bawaan untuk interaktivitas dan pemantauan

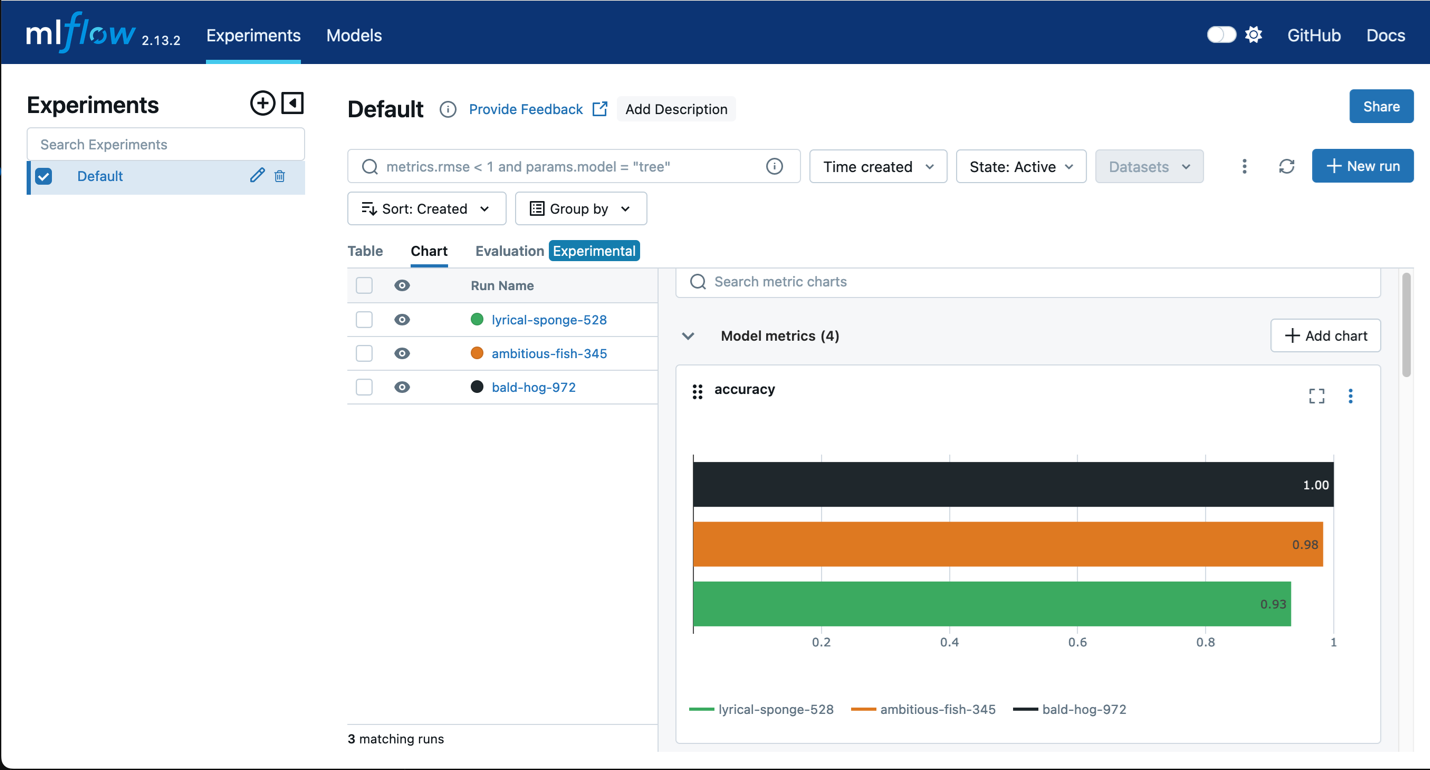

Amazon SageMaker dengan MLflow

Gunakan MLflow dengan pelatihan SageMaker untuk menangkap parameter, konfigurasi, dan hasil input, yang membantu Anda mengidentifikasi model beperforma terbaik dengan cepat untuk kasus penggunaan Anda. UI MLflow memungkinkan Anda menganalisis upaya pelatihan model dan mendaftarkan model kandidat dengan mudah untuk produksi dalam satu langkah cepat.

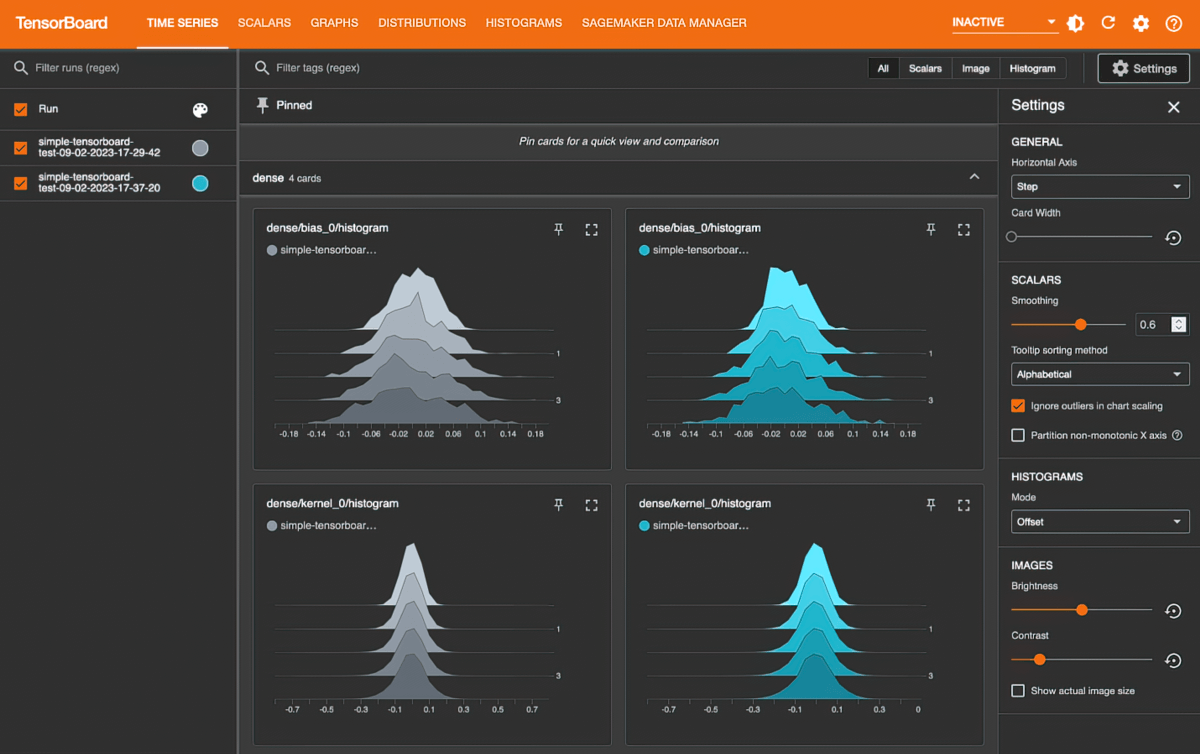

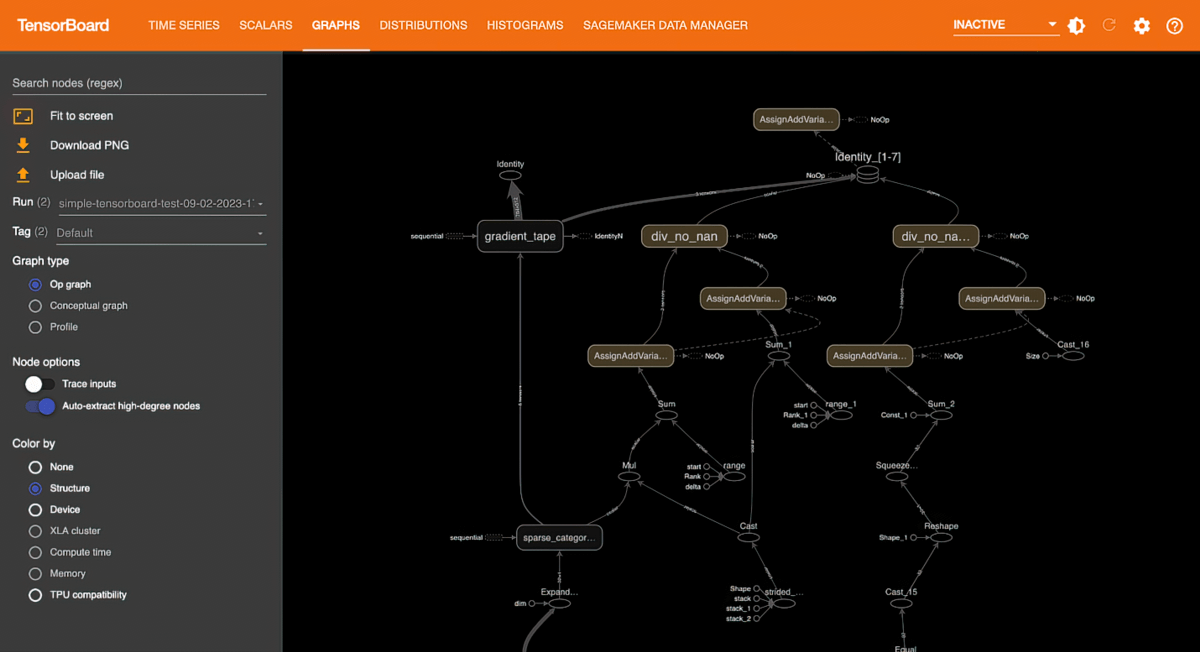

Amazon SageMaker dengan TensorBoard

Amazon SageMaker dengan TensorBoard membantu Anda menghemat waktu pengembangan dengan memvisualisasikan arsitektur model untuk mengidentifikasi dan memulihkan masalah konvergensi, seperti kehilangan validasi yang tidak konvergen atau menghilangnya gradien.

Pelatihan yang fleksibel dan lebih cepat

Kustomisasi penuh

AI SageMaker dilengkapi dengan pustaka dan alat bawaan agar pelatihan model menjadi lebih mudah dan cepat. SageMaker AI bekerja dengan model ML sumber terbuka yang populer, seperti GPT, BERT, dan DALL·E; kerangka kerja ML, seperti PyTorch dan TensorFlow; serta transformator, seperti Hugging Face. Dengan AI SageMaker, Anda dapat menggunakan pustaka dan alat sumber terbuka populer, seperti DeepSpeed, Megatron, Horovod, Ray Tune, dan TensorBoard, berdasarkan kebutuhan Anda.

Konversi kode lokal

Amazon SageMaker Python SDK membantu Anda menjalankan kode ML yang ditulis dalam lingkungan pengembangan terintegrasi (IDE) pilihan Anda dan notebook lokal bersama dengan dependensi runtime terkait sebagai tugas pelatihan model ML berskala besar dengan perubahan kode minimal. Anda hanya perlu menambahkan baris kode (dekorator Python) ke kode ML lokal Anda. SDK Python SageMaker mengambil kode bersama dengan set data dan pengaturan lingkungan ruang kerja serta menjalankannya sebagai tugas Pelatihan SageMaker.

Alur kerja pelatihan ML otomatis

Dengan mengotomatisasi alur kerja pelatihan menggunakan Amazon SageMaker Pipelines, Anda dapat membuat proses berulang untuk mengorkestrasi langkah-langkah pengembangan model untuk eksperimen dan pelatihan ulang model yang cepat. Anda dapat secara otomatis menjalankan langkah-langkah secara berkala atau ketika peristiwa tertentu dimulai, atau Anda dapat menjalankannya secara manual sesuai kebutuhan.

Rencana pelatihan yang fleksibel

Untuk memenuhi jadwal dan anggaran pelatihan, SageMaker AI membantu Anda membuat rencana pelatihan paling hemat biaya yang menggunakan sumber daya komputasi dari banyak blok kapasitas komputasi. Setelah Anda menyetujui rencana pelatihan, SageMaker AI secara otomatis menyediakan infrastruktur dan menjalankan tugas pelatihan pada sumber daya komputasi ini tanpa memerlukan intervensi manual, sehingga menghemat waktu berminggu-minggu yang diperlukan untuk mengelola proses pelatihan guna menyelaraskan tugas dengan ketersediaan komputasi.